Varidata 新闻资讯

知识库 | 问答 | 最新技术 | IDC 行业新闻Varidata 官方博客

日本GPU服务器如何提升深度学习性能

发布日期:2025-11-10

在人工智能的前沿领域,日本GPU服务器已成为深度学习计算的重要力量。这些由最先进的NVIDIA GPU驱动的专业硬件配置,正在革新研究人员和企业处理复杂AI工作负载的方式。让我们深入探讨这些系统如何优化深度学习性能的技术层面。

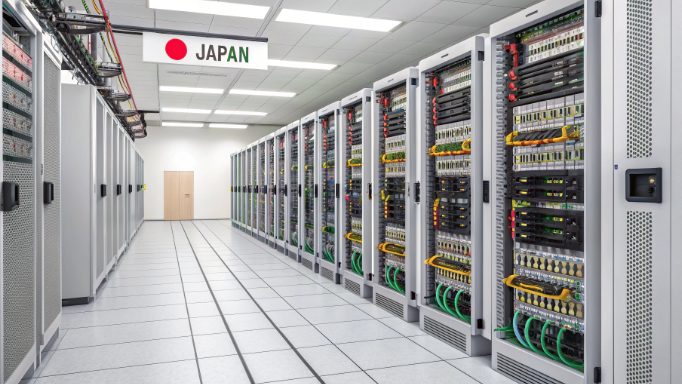

基础设施基石:日本数据中心卓越性

承载GPU服务器的日本数据中心因其卓越的基础设施设计而脱颖而出。这些设施具有以下几个关键优势:

- 99.999%运行时间保证的冗余电力系统

- 先进的抗震隔离技术

- 多层冷却架构

- 主要互联网交换节点的直接连接

硬件架构深度剖析

现代日本GPU服务器通常具备以下高性能组件:

- 配备NVLink互联的NVIDIA A100/H100 GPU集群

- 增强带宽的PCIe Gen 4.0接口

- 高频DDR5 ECC内存

- 企业级NVMe存储阵列

技术性能优化

了解提升深度学习性能的技术优化对AI从业者来说至关重要。日本GPU服务器实施了多项精密的优化方案:

- 多GPU同步

- 用于高效梯度共享的环形全归约架构

- NVIDIA NCCL库优化

- 定制InfiniBand架构配置

- 内存管理

- 层级化内存结构

- 动态内存分配

- 零拷贝内存传输

软件堆栈优化

软件生态系统在最大化GPU服务器性能方面发挥着关键作用:

- CUDA 12.0+张量运算优化

- cuDNN 8.x深度学习基元实现

- TensorRT推理加速集成

- 针对日本工作负载的定制内核优化

实际性能指标

在日本GPU服务器租用环境中观察到的实际性能提升:

- 与标准配置相比,训练吞吐量提升2.8倍

- 内存带宽利用率达到95%

- 网络延迟降低至亚毫秒级别

- 通过先进冷却系统提升电能效率40%

工作负载专用配置

不同的深度学习任务需要专门的设置以实现最佳性能:

- 计算机视觉任务

- 8片NVIDIA A100 GPU配置

- 512GB系统内存

- 4TB NVMe存储RAID 0阵列

- 25GbE网络接口

- 自然语言处理

- 16片NVIDIA H100 GPU设置

- 1TB系统内存

- 8TB分布式存储

- 100GbE网络

成本效益分析

深入了解日本GPU服务器租用解决方案的投资回报率显示出显著优势:

- 运营成本

- 电力消耗优化降低成本35%

- 冷却效率提升节省25%能源

- 通过预测性分析降低维护成本

- 性能收益

- 训练时间缩短70-80%

- 模型准确度提升2-5%

- 资源利用率提升40%

实施最佳实践

为充分发挥日本GPU服务器的潜力,请考虑以下技术指南:

- 数据管道优化

- 使用NVIDIA DALI实现并行数据加载

- 利用混合精度训练

- 为大批量启用梯度累积

- 资源管理

- 使用NVIDIA-SMI监控GPU内存使用

- 实施自动扩展策略

- 使用容器编排进行工作负载分配

案例研究与性能指标

近期实施案例展示了深度学习任务的显著改进:

- 图像识别项目

- 训练时间从168小时缩减至24小时

- 模型准确率从91%提升至94%

- 资源利用率提升45%

- 大型语言模型训练

- 支持1000亿参数模型训练

- 训练成本降低40%

- GPU利用率持续保持在85%

未来发展趋势

日本GPU基础设施持续发展演进:

- 下一代冷却技术

- 浸没式冷却系统

- AI驱动的热管理

- 热能回收利用

- 先进网络能力

- 400GbE连接

- 光子计算集成

- 量子就绪基础设施

结论

日本GPU服务器代表着深度学习基础设施的巅峰,将尖端硬件与优化的服务器租用环境完美结合。其在AI工作负载方面的卓越性能源于先进NVIDIA GPU技术、精密冷却系统和精心设计的数据中心设施之间的协同效应。对于寻求加速深度学习计划的组织来说,日本GPU服务器租用解决方案提供了性能、可靠性和技术卓越性的完美结合。

随着AI领域的持续发展,这些专业GPU配置将在推动机器学习和人工智能应用可能性边界方面发挥越来越关键的作用。日本工程精密性与最先进的GPU技术的结合继续为深度学习性能和效率制定新标准。