多GPU服务器中CPU与内存的优化配置

在高性能计算领域,多GPU服务器是承载复杂工作负载的核心设备——从神经网络训练到大规模仿真计算均依赖其支撑。然而,多GPU服务器的真正潜力并非仅由硬件原始参数决定,而是取决于CPU、内存与GPU阵列之间的精妙配合。本文将深入探讨如何将独立组件整合为协同系统的架构原则,并重点关注中国香港服务器租用等对性能与精度均有高要求的场景。

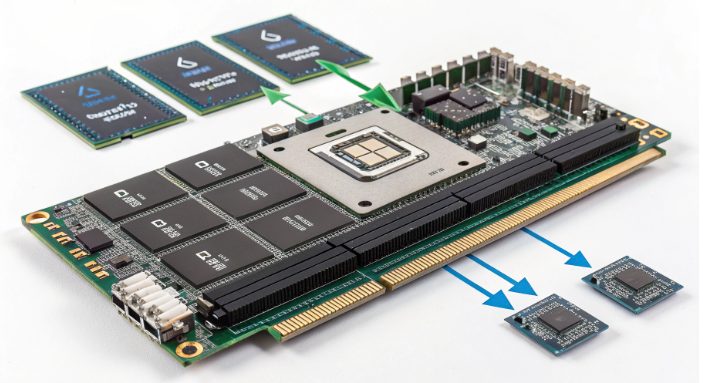

核心三角架构:CPU与内存如何支撑GPU高效运行

GPU擅长并行计算,但任务调度与数据预处理需依赖CPU完成,而主机与设备间的数据传输则由内存承担。忽视这种相互依赖关系会导致效率损耗:内存速度不足会使GPU陷入“数据饥饿”,CPU核心数量失衡则会因协调过多加速器而不堪重负。在中国香港服务器托管等高密度部署环境中,此类问题会进一步放大——因此硬件协同对维持稳定性能至关重要。

CPU架构:跳出“核心数量越多越好”的误区

核心密度固然重要,但CPU与GPU数量的匹配关系远比单纯追求核心数更复杂。一个平衡的起点是:确保CPU核心数量足以应对预处理、任务分发与系统管理需求,同时避免成为GPU流水线的瓶颈。核心数量过少会导致调度延迟,过多则会产生管理开销,反而抵消并行计算的优势。

- 时钟频率特性:低延迟任务(如实时推理)更适合高基础频率(2.0GHz以上)的CPU,以确保PCIe数据传输的快速处理。对于分布式工作负载,优先考虑核心效率而非单纯核心数量,可减少进程间通信延迟。

- 缓存一致性策略:足够的L3缓存(通常需32MB以上)可减少对主内存的重复读取,这对CPU预处理数据后再传输给GPU的场景(如机器学习流水线中的特征提取)尤为关键。

- 扩展架构设计:选择具备充足PCIe通道的CPU,避免总线拥堵,确保每个GPU都能获得专属带宽以实现无阻碍的数据流动。

内存设计:构建高效数据传输通道

内存是连接CPU逻辑控制与GPU计算的桥梁,需在容量、速度与可靠性之间取得精准平衡。核心目标是:避免因数据瓶颈导致GPU利用率下降,同时防止因内存不足引发磁盘交换(一种严重影响性能的操作)。

- 容量基础原则:内存容量应与GPU显存(VRAM)同步扩展,以容纳中间数据与控制结构,确保工作数据集可存储在高速访问区域,而非溢出到低速存储介质。

- 频率与通道配置:多通道架构下的高速内存模块(如DDR4-3200+或DDR5-4800+)可最大化带宽,满足现代GPU阵列的吞吐量需求。DIMM内存需对称安装,确保内存控制器负载均衡。

- 高负载可靠性保障:纠错内存(ECC内存)对长时间运行的任务(如AI训练)不可或缺,可防止数据损坏导致训练或仿真中断。此外,需采用具备坚固散热片的内存模块,确保其在紧凑服务器环境中保持稳定。

面向不同工作负载的调优策略

实际性能表现取决于硬件与工作负载特性的匹配度,以下为典型场景的配置思路:

深度学习工作流

此类场景中,CPU负责数据预处理,GPU执行张量运算。具备充足线程数的CPU可实现无延迟的并行预处理,搭配足量内存以缓存数据批次与模型中间状态——确保GPU流水线持续高效运行。

科学计算流水线

仿真计算需要CPU与GPU的紧密同步。核心效率与内存速度的平衡可减少数据传输延迟,这对迭代算法尤为关键(此类算法中,微小延迟会在数百万次计算中不断累积)。

图形渲染集群

大规模场景数据需充足内存以避免磁盘I/O瓶颈,而多核心CPU可将数千个渲染任务分配至各GPU,同时在交互式预览模式下保持响应速度。

中国香港服务器租用:本地化硬件考量

区域数据中心存在独特约束条件:高密度机柜布局、严格的兼容性标准,以及对能在复杂散热环境中稳定运行的硬件需求。

- 平衡之道:性能与实用性的权衡

- 入门级部署优先考虑高性价比扩展,将中端CPU、内存与少量GPU搭配,适用于科研或小规模应用场景。

- 企业级集群则需采用高端组件,确保每个GPU在7×24小时生产环境中均能以峰值效率运行。

- 前瞻性设计要点

- 在PCIe通道与DIMM插槽中预留扩展空间,避免因硬件升级导致整体更换。

- 热插拔架构可实现无缝扩展,对无法承受基础设施更新 downtime 的企业而言至关重要。

常见误区及规避方法

即便是经验丰富的工程师也可能面临挑战,以下为主要陷阱及规避策略:

- 核心数量陷阱

- 超出合理范围的CPU-GPU比例会增加调度开销,导致管理任务消耗的资源超过计算收益。

- 使用性能分析工具识别闲置核心,根据实际工作负载需求调整配置。

- 内存通道配置失衡

- DIMM内存非对称安装会使有效带宽减半——务必遵循主板指南进行对称通道配置。

- 监控内存利用率指标,确保所有通道均以满负荷运行。

- 显存-内存不匹配

- 内存不足会迫使GPU等待数据,表现为计算阶段的低利用率。

- 优化数据流水线或升级内存,确保加速器能持续获得任务数据。

性能验证:确保系统高效运行

部署完成后,需通过严格测试充分释放系统潜力:

- 运行基准测试套件,测量内存带宽与CPU-GPU协同效率。

- 使用硬件监控工具跟踪温度与利用率指标,确保组件在运行限制范围内工作——这在紧凑的服务器托管环境中尤为关键。

- 通过A/B测试迭代优化配置,基于实际性能数据而非理论参数进行微调。

归根结底,多GPU服务器的优化核心在于构建“组件互补”的系统。通过关注架构平衡——使CPU核心效率与GPU并行能力匹配、确保内存成为无缝数据通道、并适配区域基础设施需求——工程师可打造出性能稳定的高性能计算环境。无论部署于中国香港服务器租用机房还是全球集群,核心目标始终一致:消除瓶颈,让硬件生态系统发挥最大潜力。