构建中日跨域GPU计算集群

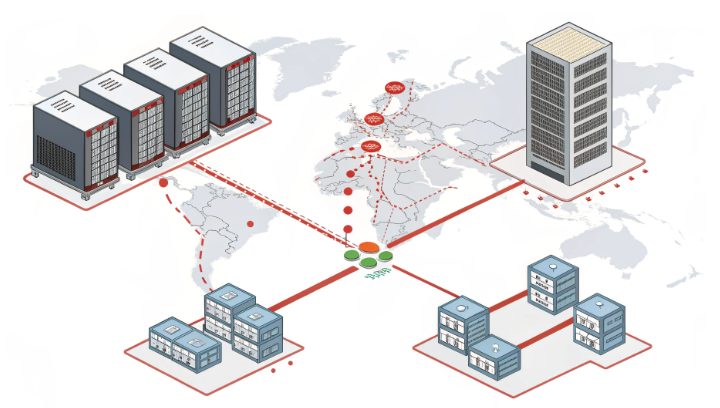

在计算需求呈指数级增长的时代——尤其是AI训练、科学仿真与数据密集型工作负载场景下,构建覆盖中日两国的跨域GPU计算集群已成为一种战略性解决方案。该架构借助地理邻近优势(区域数据枢纽间的低延迟连接)与分布式计算技术,突破单一区域的算力局限。本文将深入剖析此类集群的设计、部署与优化技术细节,专为寻求跨域算力协同价值的技术人员打造。

为何需要跨域GPU集群?核心价值解析

不同区域的计算生态往往具备互补优势:日本数据中心以网络稳定性、东亚地区低延迟连接及严格的数据保护合规性著称;而中国的基础设施则在规模、硬件多样性与本地网络整合能力上更具优势。将两者整合为统一的GPU集群,可实现:

- 算力资源池化,支撑大规模神经网络训练等计算密集型任务

- 地理冗余部署,确保区域故障时的高可用性

- 通过战略性数据布局,满足不同区域的数据驻留合规要求

核心挑战在于构建一套兼顾性能、安全性与合规性的无缝基础设施。下文将拆解其关键组成部分。

架构基础:集群蓝图设计要点

高效的集群设计需从三个关键维度开展需求分析:

1. 明确计算需求规格

首先需对工作负载特性进行建模:

- GPU选型:根据任务需求判断是否需要高吞吐量GPU(用于并行处理)或低延迟GPU(用于实时推理)。核心考量因素包括内存带宽、计算性能及与现有软件栈的兼容性。

- 节点规模规划:通过分析并行化潜力估算所需节点数量。Horovod、PyTorch分布式数据并行(DDP)等框架可支持数百块GPU的扩展,但随着节点数量增加,网络拓扑的重要性会显著提升。

- 延迟与带宽需求:金融交易等延迟敏感型应用需亚100毫秒级往返延迟,因此需部署专用低延迟链路;而大规模数据集传输等带宽密集型任务,则需在跨区域间配置多Gbps级连接。

2. 网络架构:实现跨区域高效互联

跨域网络设计需平衡成本、性能与灵活性:

- 连接方案对比:

- 专用光纤链路:延迟极低(东京与上海间通常为50-80毫秒)且可靠性高,但部署成本较高。

- SD-WAN解决方案:具备动态路由与成本效益优势,适合对绝对最低延迟要求不高的可扩展场景。

- VPN隧道:可为非敏感流量提供基础安全保障,但会引入额外开销,可能降低GPU间通信性能。

- 负载均衡策略:基于实时资源利用率实现区域感知的流量路由。在两国均部署节点的双活架构,既能确保故障切换的韧性,又能优化数据本地化访问效率。

- QoS保障:通过区分服务(DiffServ)或集成服务(IntServ)模型,优先保障集群管理流量(如调度器通信),避免其被尽力而为型网络流挤占带宽。

3. 软件栈:分布式资源编排工具选型

需选择适配跨域环境的工具:

- 集群管理系统:

- Slurm:适用于高性能计算(HPC)工作负载,具备成熟的多站点资源分配支持。

- Kubernetes:适合容器化应用,对分布式微服务架构提供原生支持。

- 分布式计算框架:需针对跨区域通信进行优化。根据工作负载的可扩展性特征,选择模型并行(跨区域拆分模型)或数据并行(跨区域分发数据分片)方案。

- 存储解决方案:部署Ceph、NFS等分布式文件系统,并结合区域缓存减少跨域数据传输。高I/O节点中的本地SSD可缓存频繁访问的数据集。

部署流程:从环境搭建到集群初始化

需按结构化阶段执行部署,确保跨区域一致性:

1. 环境准备

- 基础镜像配置:创建预安装GPU驱动(如CUDA工具链)与区域配置( locale、时区)的标准化操作系统镜像,缩短节点部署时间。

- 硬件兼容性测试:验证GPU型号与集群工具的兼容性,并同步所有节点的固件版本,避免驱动不匹配问题。

- 合规性初始化:部署防火墙、入侵检测系统等安全工具,并配置数据静态加密与传输加密,满足中日两国法规要求。

2. 集群引导配置

建立节点间通信与资源发现机制:

- 服务注册与发现:部署Consul、etcd等分布式注册中心,确保节点在动态网络环境中也能跨区域发现彼此。

- 共享存储配置:在所有节点上挂载分布式文件系统,实现数据集的一致性访问。在远端区域使用只读缓存降低访问延迟。

- 网络初始化脚本:通过自动化脚本配置网络接口、部署RDMA(如硬件支持),并在节点启动时应用QoS策略。

3. 软件栈部署

采用基础设施即代码(IaC)工具实现可复现部署:

- 自动化工具选型:根据集群规模与复杂度,选择Ansible(无代理配置管理)或SaltStack(高速并行执行)。

- 容器化最佳实践:将应用与依赖打包为Docker、Singularity等轻量级容器,通过分层镜像减少跨区域下载时间。使用私有镜像仓库保障制品分发安全。

- 分布式服务编排:定义按区域划分的资源分配(CPU、GPU、内存)清单,使调度器能优先利用本地资源。

性能优化:跨域协同效率调优策略

需从四个关键维度进行优化,最大化集群效率:

1. 网络延迟优化

- RDMA技术部署:在硬件支持的场景下,通过远程直接内存访问绕开TCP/IP协议栈,可将GPU间通信的传输开销降低40%以上。

- TCP参数调优:根据实测往返延迟与可用带宽,配置BBR、Cubic等拥塞控制算法。

- 数据本地化:在区域存储中预处理并缓存数据集,减少跨域传输量;通过增量更新实现数据集的同步。

2. GPU资源管理

确保异构节点间资源的公平高效利用:

- 动态资源调度:为时间敏感型任务实现基于优先级的排队机制,在每个区域预留部分GPU资源用于高优先级工作负载。

- 多租户隔离:使用NVIDIA多进程服务(MPS)等技术,在不同用户或应用间划分GPU资源,且不损失性能。

- 实时监控与自动扩缩容:集成Prometheus、Grafana监控GPU利用率、内存使用量与任务队列长度,根据需求变化触发节点扩缩容策略。

3. 存储I/O性能提升

- 分层存储架构:结合本地SSD(临时数据)、区域网络附加存储(NAS,热数据)与云存储(冷归档数据),通过分层工具实现数据自动迁移。

- 缓存策略:在计算节点附近部署Redis等内存缓存,加速频繁访问的元数据读取,降低文件操作延迟。

- 异步数据复制:对关键数据集采用双向复制,在保障数据一致性的同时,减少对主存储I/O的影响。

4. 软件层面优化

适配分布式架构调整算法与框架:

- 通信效率优化:在分布式训练中,通过梯度聚合技术(如fp16压缩、梯度裁剪)减少跨区域传输的数据量,降低通信开销。

- 混合精度训练:利用GPU张量核心实现混合精度计算,同时加速计算过程与跨区域数据传输。

- 故障恢复机制:在区域层面实现 checkpoint 机制,将中间状态先保存到本地存储,再与远端节点同步,缩短网络分区时的恢复时间。

监控与韧性:保障集群持续运行

需构建强健的系统以检测问题并维持可用性:

1. 分布式监控架构

- 统一监控平台:部署跨区域Prometheus集群与Grafana仪表盘,聚合中日节点的监控指标。重点跟踪以下关键数据:

- 各节点及区域的GPU利用率

- 跨域网络吞吐量与延迟

- 任务队列长度与处理时长

- 日志管理:通过ELK栈(Elasticsearch、Logstash、Kibana)集中管理日志,采用区域分片存储实现低延迟故障排查。

2. 灾备策略

- 故障切换机制:在每个区域部署备用节点,确保故障发生后分钟级接管工作负载。通过心跳检测识别节点或网络故障,触发自动切换。

- 数据备份策略:将关键数据集异步备份到远端存储,并创建时间点快照。定期测试恢复流程,确保满足恢复时间目标(RTO)与恢复点目标(RPO)要求。

- 网络冗余:部署多路径连接方案(如主用光纤+备用SD-WAN),消除跨域通信的单点故障风险。

合规性应对:跨境监管要求解析

跨境架构必须严格遵守数据保护法规:

- 中国法规合规:依据《数据安全法》《个人信息保护法》,明确数据分类策略,获取跨境传输授权,并定期开展安全审计。

- 日本法规适配:遵循《个人信息保护法》(APPI),实施严格的访问控制,对敏感数据集进行匿名化处理,并按要求向监管机构通报数据安全事件。

- 跨境数据流动:完成数据跨境传输安全评估,留存数据流向与存储位置记录,确保满足监管审计要求。

未来演进:跨域集群技术趋势

需预判影响跨域计算的技术变革方向:

- 异构计算融合:为CPU-GPU-TPU混合架构做好准备,此类架构中专用加速器将承担不同阶段的计算任务,需实现跨区域资源的动态编排。

- 边缘协同计算:在中日两国部署边缘节点进行低延迟预处理,将清洗后的精炼数据传输至核心集群执行复杂计算。

- 绿色计算实践:利用日本数据中心在可再生能源(如氢能供电)方面的部署优势,降低集群碳足迹,契合全球可持续发展目标。

构建中日跨域GPU计算集群虽具挑战性,但能带来显著价值,其实施需融合分布式系统、网络工程与合规性知识。通过聚焦架构灵活性、性能优化与法规遵从,企业可打造既能满足当前计算需求,又能适应未来挑战的强健基础设施。随着AI与数据密集型技术的持续发展,此类跨境架构将成为释放全球算力潜力的关键支撑。

无论您的需求是扩展AI训练规模、提升仿真能力,还是构建高韧性数据管道,本文阐述的原则都可为您提供基础参考,助力打造高性能、合规且具备未来适应性的跨域集群。建议从严谨的需求分析入手,优先保障低延迟连接,选择支持跨区域无缝编排的工具——分布式计算的卓越实践,始于战略设计与精细化执行。